클로바X야, 수부지 선크림 추천해 줘

(Dev + IT + ![]() )

)

![]() 9월 둘째 주 Dev

9월 둘째 주 Dev

-

- # 이슈 픽 #Best 클로바X야, 1만 원대 수부지 선크림 추천해 줘

- # 추천 픽 #꾸욱꾹이 신뢰할 수 있는 데이터를 확보하기 위한 3가지 체크리스트

- # 맛IT는 녀석들 #줍줍 아니 너 왜 10초 만에 씻고 와… 잔다면서 왜 안 자는데…

# 데브잇냥 독자탐구생활 <파이썬 크래시 코스> by morenice 님

# 데브잇냥 지식in 첫 만남에서 상대방의 마음에 >콕< 점을 찍어두는 방법

이슈 픽 #Best

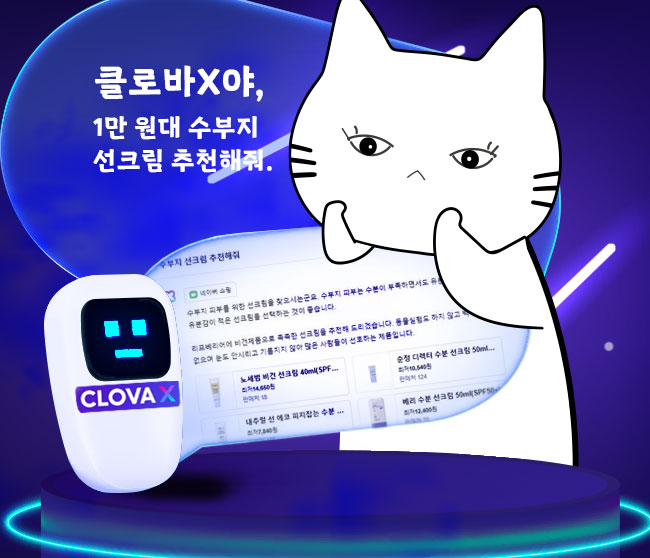

🗣️:클로바X야, 1만 원대 수부지 선크림 추천해 줘. 🖥️: 앗, 넵!(구매 링크 투척)

지난 8월 24일 네이버에서 대화형 AI ‘클로바X’를 공개했어. 네이버는 그동안 검색, 지도, 블로그, 뉴스, 커머스 등 다양한 영역에서 국내 데이터를 꾸준히 축적해왔기 때문에 챗GPT&바드와 비교했을 때 국내에 한해서는 좀 더 믿을 만한 정보를 얻을 수 있다, ‘한국에서 가장 적합하다’라고 클로바X를 소개했어.

네이버 쇼핑과 연계된 스킬 기능을 활성화하고 ‘1만 원대 수부지 선크림 추천해 줘’라고 요청하면, 수부지(수분 부족형 지성)의 설명과 함께 선크림을 구매할 수 있는 링크를 제공해 주더라고. 이게 특별한 기능인가 싶어서 챗GPT한테도 똑같이 요청해 봤는데 오히려 클로바X보다 각 제품 별로 일목요연하게 설명을 잘 해주는 거 있지? 근데 있잖아, 사진 없이 제품명이랑 설명만 던져주니까 내가 다시 네이버에 검색하고 있더라고 글쎄. 한국에서 가장 적합하다는 말이 뭔지 바로 알았잖아. 챗GPT·바드와 비교한 클로바X 체험기는 여기, 활용 방법은 여기 링크 맨 아래에서 봐줘!

추천 픽 #꾸욱꾹이

🕵️♀️신뢰할 수 있는 데이터를 확보하기 위한 3가지 체크리스트

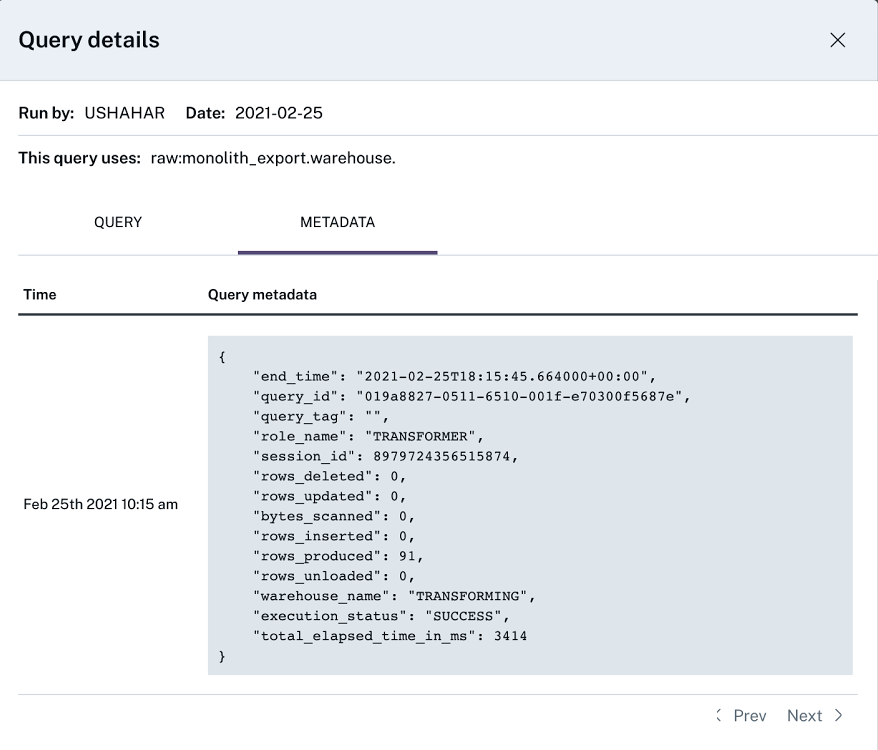

‘AI 모델에 적합한 데이터를 확보하는 것이 생성 AI 스타트업들에게 중요한 변수다’라는 얘기를 지난 뉴스레터에서 언급했었어. 근데 데이터를 확보하는 것만큼이나, 확보한 데이터의 신뢰성도 중요해. 생성 AI는 학습한 데이터만큼만 똑똑해진다는 이야기가 있는데, 품질이 떨어거나 특정 편향된 데이터로 학습한다면 우리가 AI로부터 얻는 데이터를 전혀 신뢰할 수 없는 상황이 되겠지. 데이터 품질 문제는 비단 AI 분야에서만 중요한 게 아니야. 기업용 데이터베이스 업체인 줌인포에 따르면 2019년도에만 약 20%의 기업이 데이터 품질 문제로 인해 고객을 잃는 경험을 했고, 데이터 조직이 데이터 품질 문제를 처리하기 위해 전체 업무 시간의 40% 이상을 소모한다는 조사 결과도 있어.

하지만 저품질 데이터, 불량 데이터의 발생을 완전히 막는 건 거의 불가능하기 때문에 문제가 발생했을 때 적절하게 대처하는 것이 중요해. 대처의 첫걸음은 ‘무엇을 체크하면 되는지 인식’하는 건데, 데이터 파이프라인에 오류가 생겼거나 데이터를 신뢰할 수 없는 상황이 닥쳤을 때 확인하면 좋은 3가지 체크리스트를 알려줄게. ①데이터 품질 문제의 원인을 찾는 체크리스트, ②로직 변경 관련 체크리스트, ③ETL 로그 확인 시 활용할 만한 체크리스트. 각 체크리스트의 상세 확인 항목은 여기에서!

맛IT는 녀석들 #줍줍

재미난 소식과 알짜 정보들을 물어왔다냥 🐟🐭

- [정보] LLM 너도 나도 업무에 사용해보자: To Beginner

LLM(Large Language Model)은 기본 동작은 정해진 데이터의 수많은 말뭉치에서 패턴을 익혀 주어진 텍스트와 어울리는 다음 텍스트를 생성하는 거야. 그래서 소설 이어 쓰기 같은 건 할 수 있지만 최신 뉴스에 관한 걸 질문하면 이상한 대답을 하는 거지. 단순한 LLM 사용을 넘어 검색 엔진이나 쇼핑, 문서 요약 등의 서비스와 접목해서 기능을 확장하면 ‘한화 팬에게 경기 기록 요약해서 알림톡 보내주기’, ‘의자를 검색한 사람에게 인기 상품 10개 정보 요약해 주기’와 같은 시나리오를 구현할 수 있대. 참고로 외부에 최초 공개하는 네이버 사내 개발자 행사의 발표 내용이야. 그렇담 또 한번 봐줘야지 흠흠! - [뉴스] 대기업·스타트업까지 모두 나선 LLM 개발, 얼마나 살아남을까

LLM 개발에 뛰어든 국내 기업만 10곳이 넘어. 버블이 꺼진 메타버스, NFT와 같은 길을 가는 거 아니냐는 우려까지 나오고 있는데, 포털 분야처럼 시장의 선택을 받은 일부 LLM만 살아남을 거라는 관측도 있어. 한 전문가는 AI가 많은 데이터를 학습해야 뛰어난 성능을 지닌 LLM을 만들 수 있어서 중소기업이나 스타트업들이 충분한 데이터를 확보할 수 있을지 의문이래. 소형언어모델(sLLM) 개발도 이어지고 있으나 LLM은 학습에 사용되는 파라미터 수가 많아 컴퓨팅 리소스 등 하드웨어적 한계와 비용 문제가 있다네. - [영상] 오픈AI에 말라죽으나, 네이버에 말라죽으나

한국어 데이터에 담긴 우리의 문화, 관습, 역사가 영어권의 거대한 데이터 셋에 휩쓸려가면 안 되니까 데이터 주권 관점에서 한국어 중심 AI를 만드는 작업이 필요하다는 건 완전 동의. 하지만 국내 AI/소프트웨어 생태계 측면에서는 어떨까? 챗GPT와 바드의 양자구도에 끼어들기 위해 초거대 AI 회사만 집중 지원하게 되면, 안 그래도 거대 포털의 독과점과 폐쇄적인 특성이 강한 국내 생태계가 더 악화된다는 거지. 방금도 LLM 시장에서 중소기업이 겪는 어려움을 전했는데, 이제는 생태계 문제도 생각해 볼 때인 것 같아. - [정보] GPT-3.5 파인튜닝하기 – 🗣️: 춘식이가 누구야? 🖥️: 음…파랑색 토끼ㅎ?

챗GPT가 새로운 규칙을 배우려면 모델 훈련을 다시 해야 하는데, 시간과 비용이 만만치 않게 들어. 훈련 없이도 새로운 규칙을 설명하는 인컨텍스트 러닝(in-context learning)이 해결책이 될 수 있는데, 챗GPT에게 문맥(context)에서 추가 정보를 학습하게 하여 우리의 의도대로 출력하게 하는 거야. 쉽게 말하면 프롬프트에 삼행시를 써달라고 요청할 때 삼행시의 규칙을 같이 알려주는 거지. 최근 오픈AI에서 더 좋은 해결책으로 기업용 파인튜닝(미세조정) 서비스를 출시했어. 사전 학습된 AI 모델에 데이터를 추가 학습시키는 파인튜닝 작업을 거치면 특정 분야에 특화된 기업의 맞춤형 챗GPT를 제작할 수 있대. 오픈AI의 새로운 수익모델이 되어줄 서비스라는데 맛보기로 간단한 파인튜닝 테스트해 볼래? - [정보] 챗GPT 그 다음 세대 챗봇은?

챗봇도 사람처럼 쑥쑥 성장해 왔는데 1세대는 룰베이스와 키워드 베이스로 만들어진 챗봇으로 자동응답기st, 2세대부터 자연어 처리를 하기 시작, 3세대는 LLM을 이용한 챗봇으로 챗GPT, 바드, 클로바X가 여기에 해당해. 그렇담 4세대는? 바로 LLM과 LangChain의 결합! LangChain의 등장으로 할루시네이션 문제가 해결되고 있다는 말씀. - [정보] 아니 너 왜 10초 만에 씻고 와… 잔다면서 왜 안 자는데…

오류 빼고 대화형 AI 챗봇에게 질문했을 때 답변을 못 받은 적 없지? 마치 사귄 지 얼마 되지 않은 커플이 서로 집에 바래다주다가 영원히 집에 가지 못하는 것처럼 대화형 챗봇과 이야기를 하면 좀처럼 대화가 끝나지 않아. 이제 대화를 그만하고 싶은데 챗봇이 또 답장을 하는 바람에 억지 대화가 계속 이어지곤 해. 챗봇과의 대화가 좀 더 사람과의 대화 같아지려면 생성 모델에게 답변 시간을 가르치면 된다네?

데브잇냥 독자탐구생활

한빛냥이 선택한 독자의 소리 🐠

-

<파이썬 크래시 코스> by morenice 님프로그래밍에 충분한 경험이 있는 사람들은 파이썬 레퍼런스 문서만 읽어도 시작이 가능하지만, 개발을 처음 시작하는 사람에게는 좀 더 친절하고 숙련된 가이드가 필요하다. 이 책은 파이썬을 시작하는 사람에게 중요한 입문서 역할을 하는 책이다.(…) 개발을 시작하고 실력이 늘어가는 과정을 경험하려면 실용적인 과정이 반드시 필요하다고 생각한다. 이 책은 기본 문법뿐만 아니라 실용적인 관점에서 주요 프로젝트 실습까지 제공함으로써 입문자가 빠르게 성장하는 기반을 마련해줄 수 있는 입문서라고 생각한다.

<파이썬 크래시 코스> by morenice 님프로그래밍에 충분한 경험이 있는 사람들은 파이썬 레퍼런스 문서만 읽어도 시작이 가능하지만, 개발을 처음 시작하는 사람에게는 좀 더 친절하고 숙련된 가이드가 필요하다. 이 책은 파이썬을 시작하는 사람에게 중요한 입문서 역할을 하는 책이다.(…) 개발을 시작하고 실력이 늘어가는 과정을 경험하려면 실용적인 과정이 반드시 필요하다고 생각한다. 이 책은 기본 문법뿐만 아니라 실용적인 관점에서 주요 프로젝트 실습까지 제공함으로써 입문자가 빠르게 성장하는 기반을 마련해줄 수 있는 입문서라고 생각한다. -

<견고한 데이터 엔지니어링> by corazzon 님실무에서 일을 하다 보면 친절한 사수 없이 스스로 시행착오를 겪으며 성장해야 하는 외로운 순간이 있다. 그때 이 책이 옆에 있다면 어떨까? 이 책은 데이터 엔지니어링 업무를 하며 궁금한 A-Z까지의 내용을 친절한 사수처럼 설명한다. 견고한 데이터 엔지니어링은 실제 데이터 엔지니어링 문제 해결을 위한 탄탄한 기반 제공하는 것을 목표로 하는 책이다. 데이터 엔지니어링이란 무엇일까? 데이터를 좀 더 효과적으로 처리하고 활용하기 위한 기술 및 방법론으로 데이터와 관련된 작업을 효율적으로 하기 위한 노하우를 집대성한 책이다. 데이터 과학자, 소프트웨어 엔지니어, 데이터 팀 리더는 물론 다양한 분야의 전문가뿐만 아니라 데이터 엔지니어링 관련 업무를 시작하는 사람이거나 혹은 엔지니어링 업무를 하고 있다 하더라도 전반적인 내용을 정리해 볼 수 있는 책이다.

<견고한 데이터 엔지니어링> by corazzon 님실무에서 일을 하다 보면 친절한 사수 없이 스스로 시행착오를 겪으며 성장해야 하는 외로운 순간이 있다. 그때 이 책이 옆에 있다면 어떨까? 이 책은 데이터 엔지니어링 업무를 하며 궁금한 A-Z까지의 내용을 친절한 사수처럼 설명한다. 견고한 데이터 엔지니어링은 실제 데이터 엔지니어링 문제 해결을 위한 탄탄한 기반 제공하는 것을 목표로 하는 책이다. 데이터 엔지니어링이란 무엇일까? 데이터를 좀 더 효과적으로 처리하고 활용하기 위한 기술 및 방법론으로 데이터와 관련된 작업을 효율적으로 하기 위한 노하우를 집대성한 책이다. 데이터 과학자, 소프트웨어 엔지니어, 데이터 팀 리더는 물론 다양한 분야의 전문가뿐만 아니라 데이터 엔지니어링 관련 업무를 시작하는 사람이거나 혹은 엔지니어링 업무를 하고 있다 하더라도 전반적인 내용을 정리해 볼 수 있는 책이다.